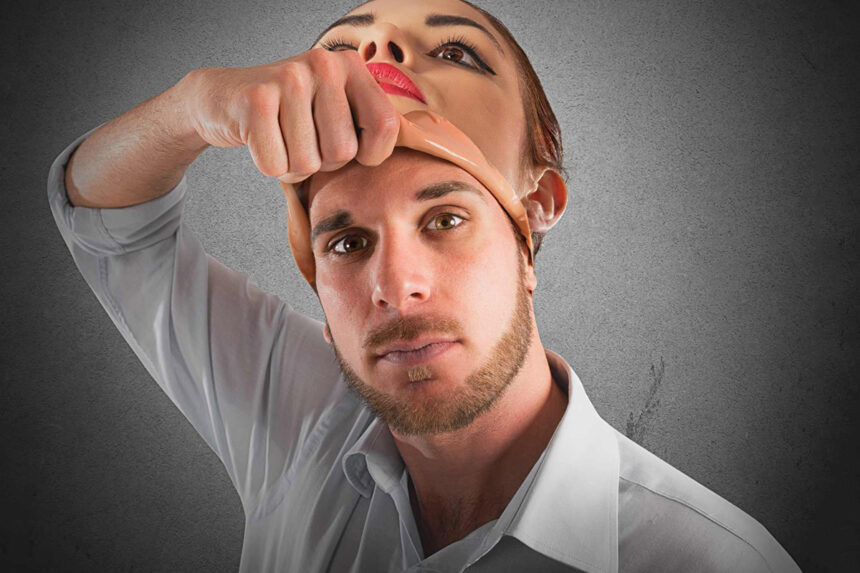

Технологія “deepfake” є методом синтезу зображення людини на основі технології штучного інтелекту. Сьогодні за допомогою новітніх технологій можна змусити будь-яку людину “сказати” все, що заманеться. Як розпізнати поширені зараз deepfake-відео та не стати їхньої жертвою, читайте у статті.

Що таке “deepfake”?

Технологія “deepfake”дозволяє створювати фальшиві ролики за допомогою накладання потрібних слів на вже існуюче відео або навпаки. Такі відео виглядають дуже реалістичними. Основними жертвами таких відеороликів стають знаменитості та громадські діячі. Як правило, в підробних відео відомі особистості нібито говорять щось образливе та провокаційне.

Популярність deepfake-відео зростає з кожним днем, зокрема за останній рік їх кількість збільшилась майже удвічі. Крім цього, удосконалюється і якість таких відео. Наприклад, в Інтернет-мережі поширений відеоролик з актором Біллом Гейдером, який без особливих зусиль перетворюється на Тома Круза. При цьому змінюється не тільки зовнішність, але й голос актора. Під час пошуку deepfake-відео на YouTube, ви знайдете безліч роликів з публічними особистостями на досить різні теми.

Чим небезпечні deepfake-відео?

Технологія”deepfake” набирає все більшої популярності не тільки серед звичайних користувачів, а й серед кіберзлочинців. Хоча цей тренд сприймається більш як розвага, але в подальшому такі фальшиві ролики можуть стати причиною політичних скандалів, а також бути використані в кібератаках та в інших злочинних схемах.

Все частіше технологія “deepfake” допомагає зловмисникам здійснювати різні шахрайські операції. Наприклад, шахраї, видаючи себе за генерального директора, просили терміново перевести великі суми нібито на рахунок постачальника, а насправді вказували свій рахунок. Варто зазначити, що підробити голоси особистостей, які займають керівні посади, досить легко, оскільки вони часто виступають на різних конференціях, які часто загальнодоступні на YouTube.

Deepfake-відео становлять загрозу не тільки публічним особистостям, а й звичайним користувачам, навіть вашим близьким та колегам. Наприклад, “deepfake” можуть використовуватися для знущань у школах чи офісах.

Технологія “deepfake” стає все доступнішою для будь-якого користувача, а розпізнати фальшивку стає все важче. І дійсно, фейк-технології удосконалюються з кожним днем, а ось розвиток інструментів, здатних розпізнати підроблений контент, поки знаходиться на початковому рівні. Сьогодні немає сервісу або технології, яка змогла б викрити “deepfake”. Тому залишається тільки покладатися на свою інтуїцію.

Варто зазначити, що для створення максимально реалістичного відеоролика потрібно зібрати велику кількість відео- і аудіозаписів конкретної людини, навіть для короткого кліпу. Зараз це не є великою проблемою, оскільки безліч наших фото та відео загальнодоступні в популярних соцмережах. Однак, в гонитві за віртуальною популярністю варто не забувати, що вся опублікована інформація може бути використана кіберзлочинцями.

Нагадаємо, популярна клавіатура для Android під назвою Ai.type, що має понад 40 мільйонів завантажень, містила в собі шкідливий код. Троян, прихований в додатку, займався просуванням інших додатків, демонстрацією реклами та відвідуванням різнопланових сайтів, на яких іноді оформляв підписки на платні послуги.

Окрім цього, Mozilla планує заблокувати повідомлення з проханням надсилати сповіщення сайтів за замовчуванням у Firefox. Google також може невдовзі це заблокувати у Chrome.

Також дедалі популярнішим у кіберзлочинців стає новий спосіб шахрайства, що дозволяє “обчищати” банківські рахунки користувачів Amazon. Потай від жертви зловмисники підключають до її облікового запису смарт-телевізор, який не відображається в звичайних налаштуваннях і який не може видалити навіть команда техпідтримки Amazon.

Зверніть увагу, дії в Інтернеті передбачають обмін певною особистою інформацією чи конфіденційними даними, які у разі вашої неуважності можуть опинитися в руках зловмисників. Для забезпечення захисту Ваших персональних даних під час роботи в Інтернет-мережі дотримуйтесь основних правил кібергігієни.