Вони закликають припинити розробку систем штучного інтелекту, більш прогресивних, ніж GPT-4, принаймні на шість місяців.

Ілон Маск, а також низка технічних керівників і експертів зі штучного інтелекту, інформатики та інших дисциплін у відкритому листі , опублікованому у вівторок, закликали провідні лабораторії штучного інтелекту призупинити розробку систем більш просунутих, ніж GPT-4, посилаючись на «великі ризики» для людського суспільства.

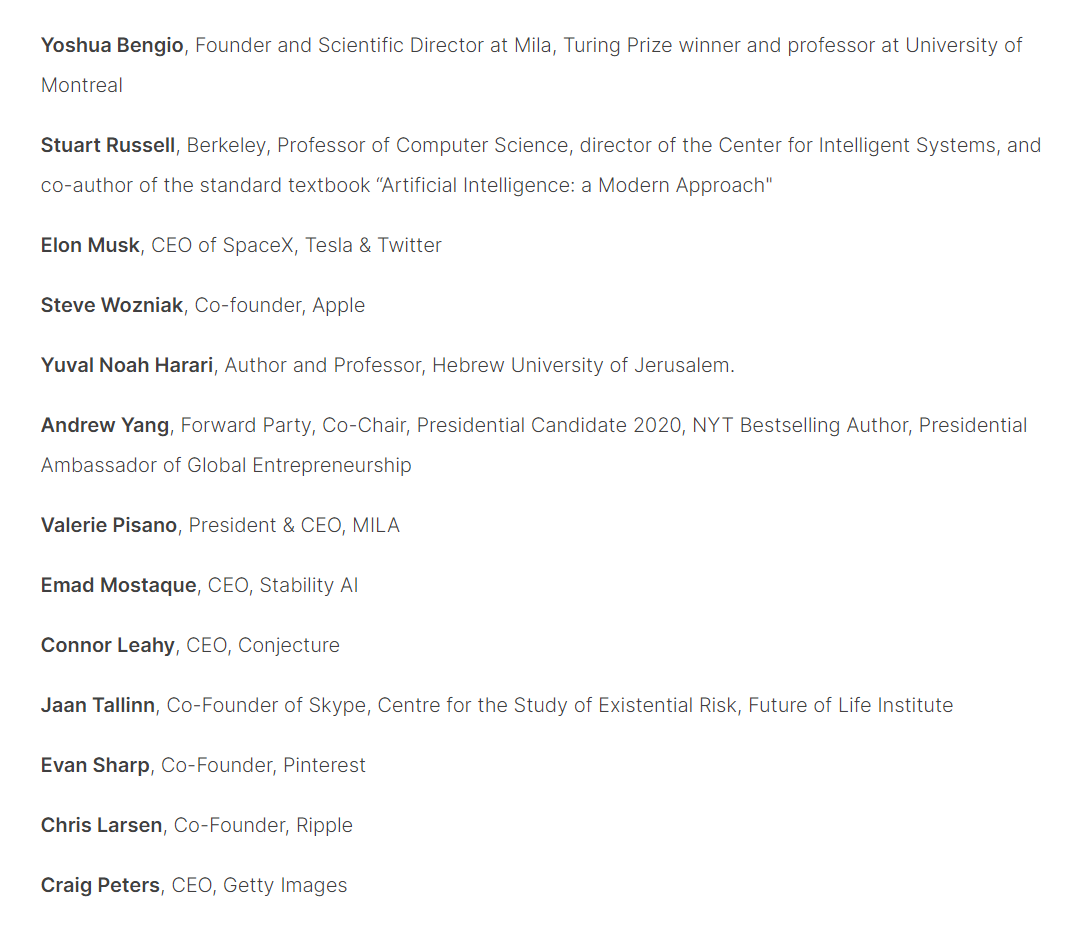

Відкритий лист, опублікований некомерційною організацією Future of Life Institute, нараховує понад 1000 підписантів, у тому числі Маск, співзасновник Apple Стів Возняк, генеральний директор Stability AI Емад Мостаке та автор Sapiens Ювал Ной Харарі. Він закликає до негайного припинення навчання систем щонайменше на шість місяців, яке має бути публічним, таким, що піддається перевірці, і включати всіх державних суб’єктів.

«Системи штучного інтелекту з конкурентоспроможним інтелектом можуть становити серйозні ризики для суспільства та людства, як показали численні дослідження та визнано провідними лабораторіями штучного інтелекту», — йдеться в листі. «Чи маємо ми дозволити машинам заповнювати наші інформаційні канали пропагандою та неправдою? Чи маємо ми автоматизувати всі робочі місця, включно з тими, які виконують завдання? Чи маємо ми ризикувати втратою контролю над нашою цивілізацією?»

Відкритий лист надійшов через кілька тижнів після публічного дебюту GPT-4 від OpenAI, великої мовної моделі, яка підтримує преміум-версію надзвичайно популярного чат-бота ChatGPT. Згідно з OpenAI, новий GPT-4 може вирішувати складніші завдання та давати більш деталізовані результати, ніж попередні версії, а також менш схильний до недоліків попередніх версій.

Щоб виконувати свою роботу, такі системи, як GPT-4, повинні бути навчені великими обсягами даних, які потім можуть використовувати для відповідей на запитання та виконання інших завдань. ChatGPT, який увірвався на сцену в листопаді, має людську здатність писати робочі електронні листи, планувати маршрути подорожей, створювати комп’ютерний код і добре складати тести, такі як адвокатський іспит.

Читайте також: Чому ми всі одержимі неймовірним чат-ботом ChatGPT AI

OpenAI не відразу відповів на запит про коментар.

Але на своєму веб-сайті OpenAI визнає необхідність гарантувати, що технологічні системи, які «загалом розумніші за людей», працюють на благо людства. «У якийсь момент може виявитися важливим отримати незалежний огляд перед тим, як почати навчання майбутніх систем, і домовитися про обмеження темпів зростання обчислювальної техніки, яка використовується для створення нових моделей».

З початку року зростаючий список компаній, включаючи Google, Microsoft, Adobe, Snapchat, DuckDuckGo і Grammarly, анонсували сервіси, які використовують переваги генеративних навичок ШІ.

Читайте також: ChatGPT проти Bing Chat: який чат-бот AI вам слід використовувати?

Власне дослідження OpenAI показало, що ці навички ШІ пов’язані з ризиками. Генеративні системи штучного інтелекту можуть, наприклад, цитувати ненадійні джерела або, як зазначає OpenAI, «збільшувати виклики безпеці, вживаючи шкідливих або ненавмисних дій, збільшуючи можливості зловмисників, які можуть обманювати, вводити в оману або зловживати ними».

Експерти зі штучного інтелекту налякані тим, куди все це може йти, а також тим, що компанії поспішно випускають продукти без відповідних гарантій або навіть розуміння наслідків.

«Просунутий штучний інтелект може свідчити про глибокі зміни в історії життя на Землі, і його слід планувати та керувати відповідною ретельністю та ресурсами», — йдеться в листі. «На жаль, такого рівня планування та управління не існує, навіть незважаючи на те, що останніми місяцями лабораторії штучного інтелекту вийшли з-під контролю за розробкою та розгортанням все більш потужних цифрових розумів, яких ніхто — навіть їхні творці — не може зрозуміти, передбачити або надійно контролювати».

Джерело: CNET