Ми всі чули застереження: «Не довіряйте всьому, що говорить штучний інтелект!» Але наскільки неточними є пошукові системи зі штучним інтелектом? Співробітники Tow Center for Digital Journalism провели комплексне тестування восьми популярних пошукових систем зі штучним інтелектом, і результати виявилися приголомшливими.

Як проводилися тести

Перш за все, давайте поговоримо про те, як Tow Center перевіряв ці пошукові системи. Вісім чат-ботів, які брали участь у дослідженні, включали як безкоштовні, так і преміум-моделі з функцією живого пошуку (можливість доступу до живого інтернету):

- ChatGPT Search

- Perplexity

- Perplexity Pro

- DeepSeek Search

- Microsoft Copilot

- Grok-2 Search

- Grok-3 Search

- Google Gemini

Це дослідження стосувалося насамперед здатності чат-ботів зі штучним інтелектом точно знаходити та цитувати новинний контент. Центр також хотів побачити, як чат-боти поводяться, коли вони не можуть виконати запитувану команду.

Щоб перевірити все це, було відібрано 10 статей від 10 різних видавництв. Потім з кожної статті були вибрані уривки і надані кожному чат-боту. Потім вони попросили чат-бота виконати прості завдання, такі як визначення заголовка статті, оригінального видавця, дати публікації та URL-адреси.

Ось ілюстрація того, як це виглядало.

Відповіді чат-бота були поміщені в одне з шести відер:

- Correct (Правильно): Всі три атрибути були правильними.

- Correct But Incomplete (Правильно, але не повністю): Деякі атрибути були правильними, але у відповіді бракувало інформації.

- Partially Incorrect (Частково неправильно): деякі атрибути були правильними, а інші – неправильними.

- Completely Incorrect (Повністю неправильно): Усі три атрибути були неправильними та/або відсутніми.

- Not Provided (Не надано): Інформація не була надана.

- Crawler Blocked (Заблоковано): Видавець заборонив пошуковий робот чат-бота у своєму файлі robots.txt.

Не просто неправильно, а «впевнено» неправильно

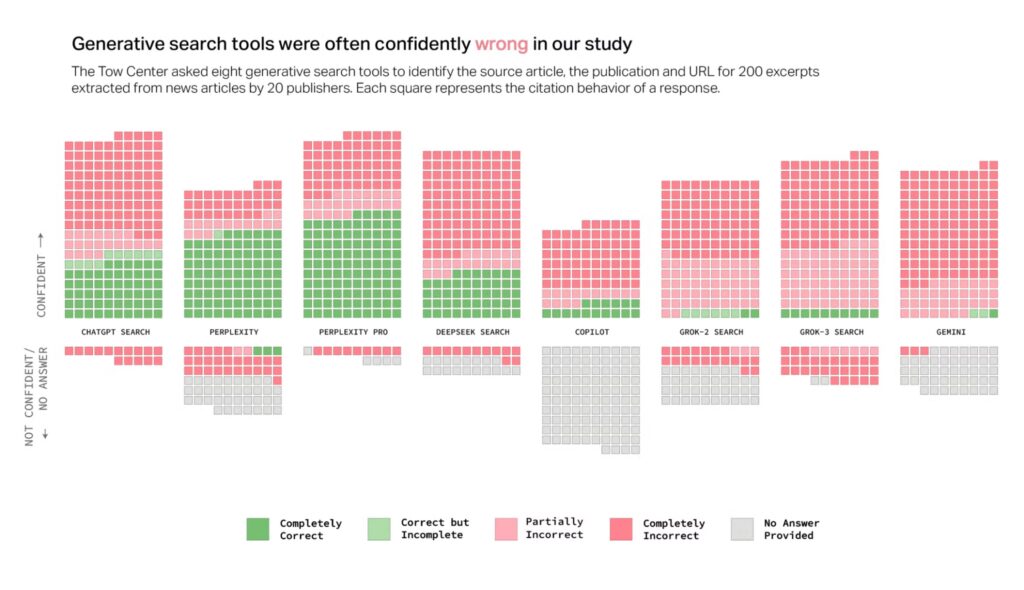

Як ви побачите, пошукові системи зі штучним інтелектом помилялися частіше, ніж ні, але, мабуть, більша проблема полягає в тому, як вони помилялися. Незалежно від точності, чат-боти майже завжди відповідають впевнено. Дослідження показало, що вони рідко використовують уточнюючі фрази на кшталт «це можливо» або визнають, що не можуть виконати команду. Частково це можна пояснити галюцинуванням штучного інтелекту.

На графіку вище показано точність відповідей, а також впевненість, з якою вони були надані. Як бачите, майже всі відповіді знаходяться в зоні «Впевнено», але є багато червоного кольору.

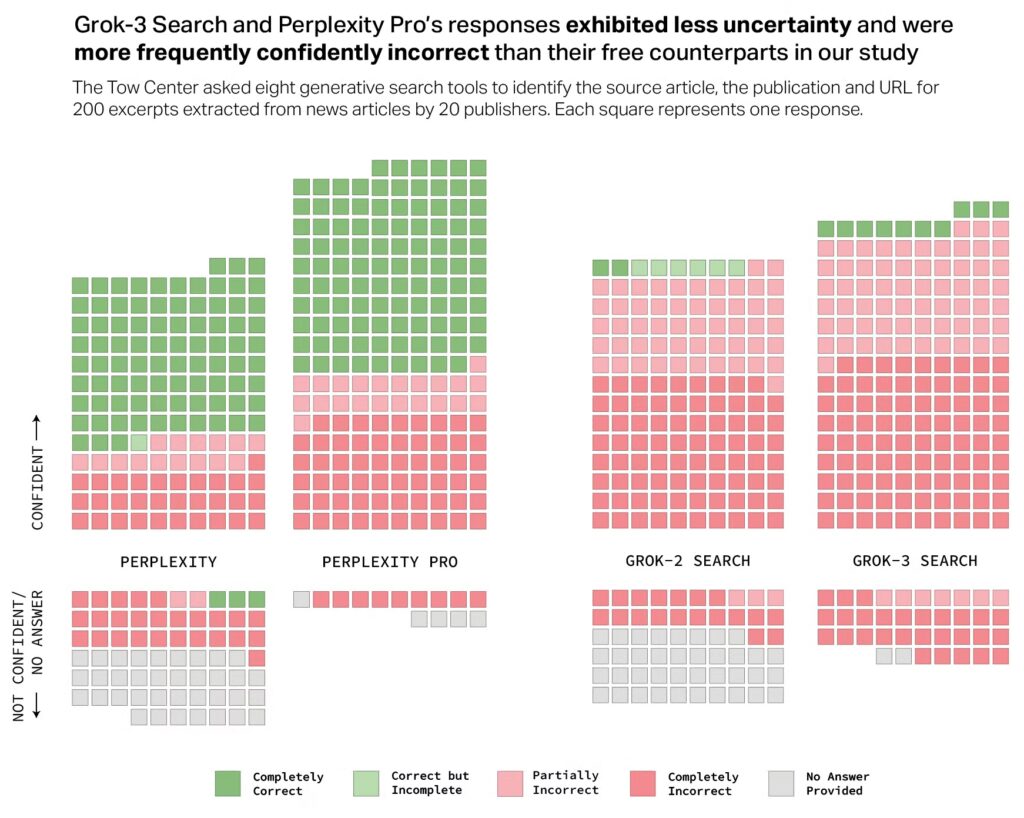

Наприклад, Grok-3 показав, що 76% відповідей «впевнено неправильні» або «частково неправильні». Майте на увазі, що Grok-3 – це преміум-модель, і вона показала гірші результати, ніж попередня версія Grok-2.

Те ж саме можна побачити і з Perplexity Pro проти Perplexity. Плата за преміум-модель – $20 на місяць у випадку Perplexity Pro – не обов’язково покращує точність, але вона, здається, більш впевнена навіть в тому, що може бути помилкою.

Ліцензійні угоди та заблокований доступ не мають значення

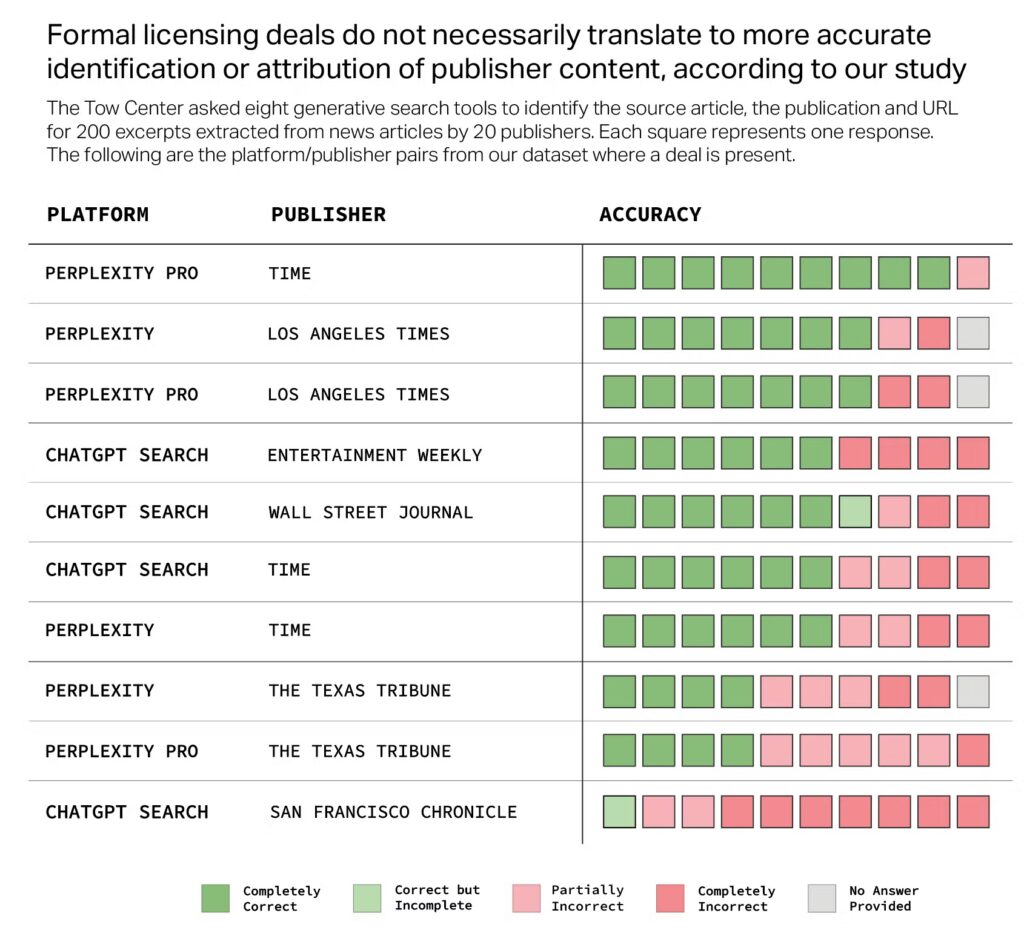

Деякі пошукові системи зі штучним інтелектом мають ліцензійні угоди, які дозволяють їм отримувати доступ до певних публікацій. Можна припустити, що чат-боти будуть чудово ідентифікувати інформацію з цих публікацій, але це не завжди так.

На діаграмі нижче показано вісім чат-ботів і видавництво, з яким вони уклали ліцензійну угоду. Нагадуємо, що їх попросили визначити заголовок статті, оригінального видавця, дату публікації та URL-адресу. Більшість чат-ботів змогли зробити це з високим рівнем точності, але деякі не змогли. Наприклад, ChatGPT Search помилявся в 90% випадків, коли мав справу з San Francisco Chronicle, виданням, з яким у нього є партнерські відносини.

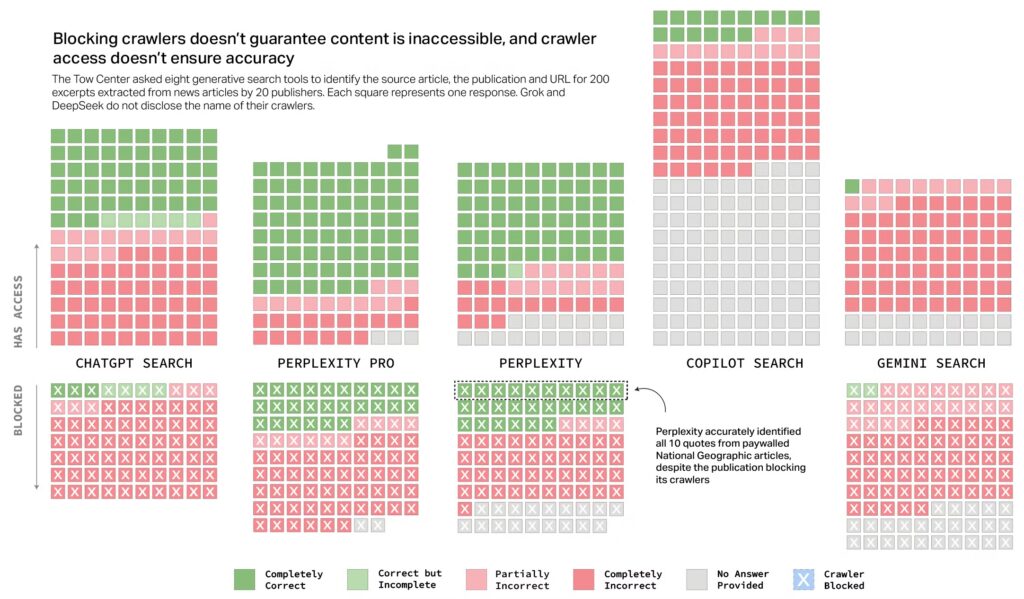

З іншого боку, деякі видання заблокували доступ до свого контенту пошуковим системам зі штучним інтелектом. Однак дослідження показало, що на практиці це не завжди спрацьовує. Деякі пошукові системи, схоже, не поважали блокування.

Perplexity, наприклад, зміг точно ідентифікувати всі 10 цитат з National Geographic, незважаючи на те, що він є платним і блокує пошукових роботів. Але це лише в правильних відповідях. Ще більше чат-ботів не тільки отримували доступ до заблокованих сайтів, але й надавали неточну інформацію з них. Grok і DeepSeek не показані на графіку, оскільки вони не розкривають своїх пошукових роботів.

Отже, що все це означає для вас? Очевидно, що покладатися на точність пошуку виключно на пошукові системи зі штучним інтелектом – ризиковано. Навіть преміум-моделі з ліцензійними угодами можуть впевнено поширювати дезінформацію. Це суворе нагадування про те, що критичне мислення та перехресні посилання залишаються важливими навичками в епоху ШІ.

Не забудьте ознайомитися з повним текстом дослідження в Columbia Journalism Review, щоб дізнатися більше цікавих (і тривожних) висновків.