Технологія дипфейків розвивається настільки швидко, що відрізнити справжнє відео від штучного стає все складніше. Але не все втрачено — існують певні ознаки, які можуть допомогти вам розпізнати AI-генерований контент, навіть коли він виглядає надзвичайно реалістично.

Нова реальність цифрового контенту

Пам’ятаєте часи, коли “підробка” в інтернеті означала погано відфотошоплене зображення? Ах, які це були прості часи. Тепер ми всі плаваємо в морі відео, згенерованих штучним інтелектом, та дипфейків — від фальшивих відео знаменитостей до неправдивих новин та шахрайських схем. Відрізнити справжнє від штучного стає майже неможливим.

Ситуація ускладнюється. Інструмент для створення відео Sora від OpenAI вже розмиває межі між реальністю та штучним контентом. Нещодавно з’явився Sora 2 — вірусний “додаток соціальних мереж”, який став найпопулярнішим продуктом в інтернеті. Особливість платформи: це стрічка в стилі TikTok лише за запрошеннями, де весь контент на 100% штучний.

Експерти називають це “дипфейковим маренням”, і це точне визначення. Платформа щодня вдосконалюється у створенні фікції, яка виглядає як факт, а ризики величезні.

Що таке дипфейки і чому вони небезпечні

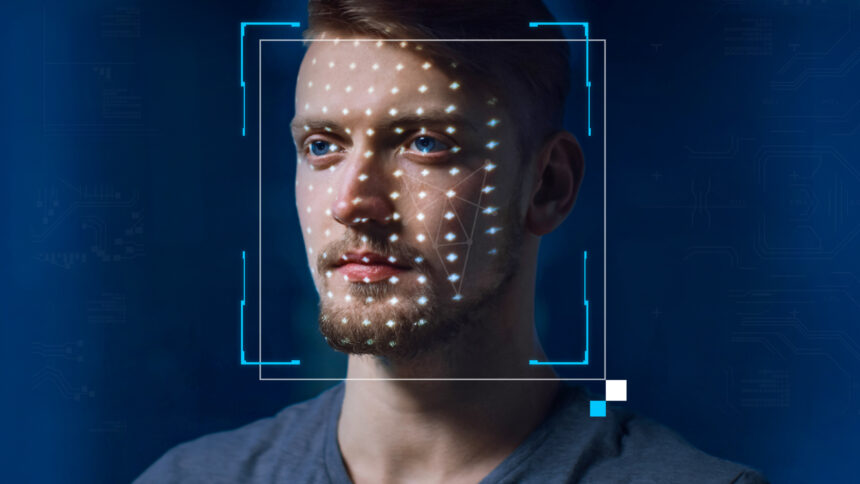

Дипфейки — це відео, аудіо або зображення, створені за допомогою штучного інтелекту, які показують людей, які говорять або роблять речі, яких вони насправді ніколи не говорили чи не робили. Технологія використовує глибоке навчання (deep learning) для аналізу тисяч зображень особи та створення переконливої підробки.

Проблема полягає в тому, що дипфейки можуть використовуватися для поширення дезінформації, шантажу, порнографії без згоди або навіть для впливу на вибори. За даними дослідження компанії Deeptrace, кількість дипфейк відео в інтернеті зросла на 900% лише за один рік.

Технічні можливості Sora

З технічної точки зору відео Sora вражають порівняно з конкурентами, такими як Midjourney V1 та Google Veo 3. Вони мають високу роздільну здатність, синхронізований звук та дивовижну креативність. Найпопулярніша функція Sora, яку називають “cameo”, дозволяє використовувати зовнішність інших людей та вставляти їх практично в будь-яку сцену, створену ШІ. Результат — неймовірно реалістичні відео.

Саме тому багато експертів стурбовані Sora. Додаток полегшує створення небезпечних дипфейків, поширення дезінформації та розмиває межу між реальним та штучним. Публічні особи та знаменитості особливо вразливі до таких дипфейків, а профспілки на кшталт SAG-AFTRA закликали OpenAI посилити захисні механізми.

Як перевірити контент на ШІ

Ідентифікація контенту, створеного штучним інтелектом, залишається постійним викликом для технологічних компаній, соціальних платформ та звичайних користувачів. Проте ситуація не безнадійна. Існує кілька способів визначити, чи було відео створено за допомогою Sora.

Водяний знак Sora

Кожне відео, створене в додатку Sora для iOS, містить водяний знак при завантаженні. Це білий логотип Sora у вигляді хмари, який переміщується по краях відео — подібно до того, як маркуються відео TikTok.

Маркування контенту — один з найважливіших способів, як компанії зі штучного інтелекту можуть візуально допомогти розпізнати ШІ-генерований контент. Наприклад, модель Gemini “nano banana” від Google автоматично додає водяні знаки до зображень.

Однак водяні знаки не ідеальні. По-перше, якщо знак статичний (нерухомий), його можна легко обрізати. Навіть для рухомих знаків, як у Sora, існують додатки, спеціально розроблені для їх видалення. Генеральний директор OpenAI Сем Альтман на запитання про це відповів, що суспільство має адаптуватися до світу, де будь-хто може створити фальшиві відео будь-кого. Звісно, до появи Sora не існувало популярного, легкодоступного способу створення таких відео без спеціальних навичок.

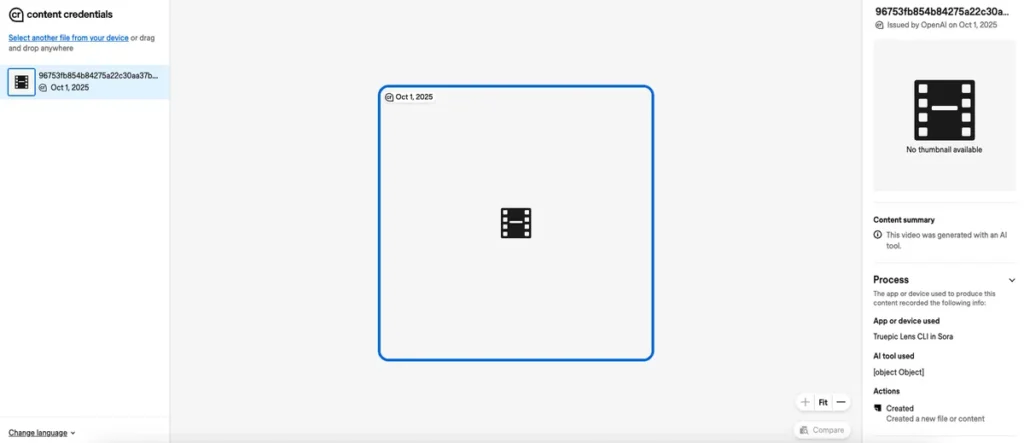

Перевірка метаданих

Метадані — це набір інформації, яка автоматично прикріплюється до контенту під час його створення. Вони надають додаткові відомості про те, як зображення чи відео було створено: тип камери для фотографії, місцезнаходження, дата та час зйомки відео, назва файлу. Кожне фото та відео має метадані, незалежно від того, чи створено його людиною, чи штучним інтелектом. Багато ШІ-контенту містить облікові дані, які вказують на його штучне походження.

OpenAI є частиною Coalition for Content Provenance and Authenticity (C2PA), тому відео Sora включають метадані C2PA. Користувачі можуть скористатися інструментом перевірки Content Authenticity Initiative для аналізу метаданих відео, зображення чи документа.

Як перевірити метадані фото, відео або документа:

- Перейдіть за посиланням: https://verify.contentauthenticity.org/

- Завантажте файл, який потрібно перевірити

- Натисніть “Відкрити”

- Перевірте інформацію на правій панелі — якщо контент створено ШІ, це має бути зазначено в розділі summary

Коли відео Sora перевіряється через цей інструмент, воно позначається як “issued by OpenAI” з відміткою про створення штучним інтелектом. Усі відео Sora повинні містити такі облікові дані.

Цей інструмент, як і всі детектори ШІ, не ідеальний. Існує багато способів уникнути виявлення для ШІ-відео. Відео, створені іншими платформами (не Sora), можуть не містити необхідних сигналів у метаданих. Наприклад, відео Midjourney не позначаються системою. Навіть якщо відео створено Sora, але потім оброблено через сторонній додаток (наприклад, для видалення водяних знаків) і перезавантажено, ймовірність його виявлення знижується.

Позначки на соціальних платформах

У соціальних мережах Meta, таких як Instagram та Facebook, існують внутрішні системи для позначення ШІ-контенту. Ці системи недосконалі, але дозволяють чітко побачити мітку на публікаціях, які було позначено. TikTok та YouTube мають подібні політики маркування ШІ-контенту.

Єдиний по-справжньому надійний спосіб дізнатися, чи є контент штучним — якщо автор розкриває це самостійно. Багато соціальних платформ тепер пропонують налаштування, які дозволяють користувачам позначати свої публікації як створені ШІ. Навіть проста примітка в описі може допомогти всім зрозуміти, як було створено контент.

Оскільки моделі штучного інтелекту, такі як Sora, продовжують розмивати межу між реальністю та ШІ, на всіх нас лежить відповідальність максимально чітко вказувати, коли щось є реальним, а коли штучним.

Як розпізнати дипфейк

Хоча дипфейки стають все досконалішими, вони все ще мають певні технічні недоліки, які можна помітити при уважному розгляді:

Проблеми з очима та морганням

Одна з найпоширеніших ознак дипфейку — неприродне моргання або його повна відсутність. Штучний інтелект часто має проблеми з відтворенням природного ритму моргання. Також зверніть увагу на:

- Різний розмір зіниць

- Неприродний блиск або відсутність відблисків в очах

- Дивний рух очей, який не відповідає напрямку погляду

- Розмиті або нечіткі краї навколо очей

Проблеми з синхронізацією губ

Навіть найкращі дипфейки можуть мати проблеми з точною синхронізацією рухів губ зі звуком. Шукайте:

- Затримку між звуком і рухом губ

- Неприродні рухи рота

- Розмиття навколо області рота

- Зміну кольору або текстури губ

Проблеми з волоссям та краями обличчя

AI часто має труднощі з відтворенням складних деталей, таких як волосся. Зверніть увагу на:

- Розмите або неприродне волосся

- Різкі переходи між обличчям і фоном

- Неприродні тіні або освітлення на обличчі

- Асиметрію обличчя або його частин

Проблеми з кольором та освітленням

Дипфейки часто мають проблеми з консистентністю кольорів та освітлення:

- Різні відтінки шкіри на різних частинах обличчя

- Неприродне освітлення, яке не відповідає оточенню

- Мерехтіння або зміна кольорів між кадрами

- Низька роздільна здатність в певних областях відео

Неприродні рухи та жести

Штучний інтелект може створити реалістичне обличчя, але часто має проблеми з природними рухами тіла:

- Роботоподібні або повторювані жести

- Відсутність природної міміки

- Незвичайні рухи голови або тіла

- Відсутність дрібних деталей, таких як зморшки при посмішці

Майбутнє боротьби з дипфейками

Технології виявлення дипфейків розвиваються паралельно з технологіями їх створення. Компанії та дослідники працюють над більш досконалими методами виявлення, включаючи аналіз біометричних даних та використання блокчейн-технологій для верифікації автентичності контенту.

Водночас важливо розуміти, що це постійна гонка озброєнь між створювачами дипфейків та тими, хто їх виявляє. Тому найкращою стратегією залишається поєднання технологічних рішень з критичним мисленням та медіаграмотністю.

У світі, де дипфейки стають все реалістичнішими, вміння їх розпізнавати стає критично важливою навичкою для кожного користувача інтернету. Пам’ятайте: якщо відео здається підозрілим, краще перевірити його автентичність, ніж поширювати потенційно хибну інформацію.

Головна рекомендація: залишайтеся пильними

Не існує одного безпомилкового методу точно визначити з першого погляду, чи є відео справжнім, чи створеним ШІ. Найкраще, що можна зробити для захисту від обману — не вірити автоматично всьому, що бачите онлайн. Довіряйте інстинктам: якщо щось здається нереальним, воно, ймовірно, таким і є.

У ці безпрецедентні часи, наповнені ШІ-контентом сумнівної якості, найкращий захист — уважніше вивчати відео. Не просто швидко переглядайте та не гортайте далі без роздумів. Шукайте спотворений текст, зникаючі об’єкти та рухи, що порушують фізичні закони. І не засмучуйтеся, якщо іноді вас обдурять — навіть експерти помиляються.