Щоб перевірити, чи може ШІ допомогти зупинити кібератаки, Google нещодавно провів експеримент, в якому використовував генеративний ШІ, щоб пояснити користувачам, чому фішингове повідомлення було позначене як загроза.

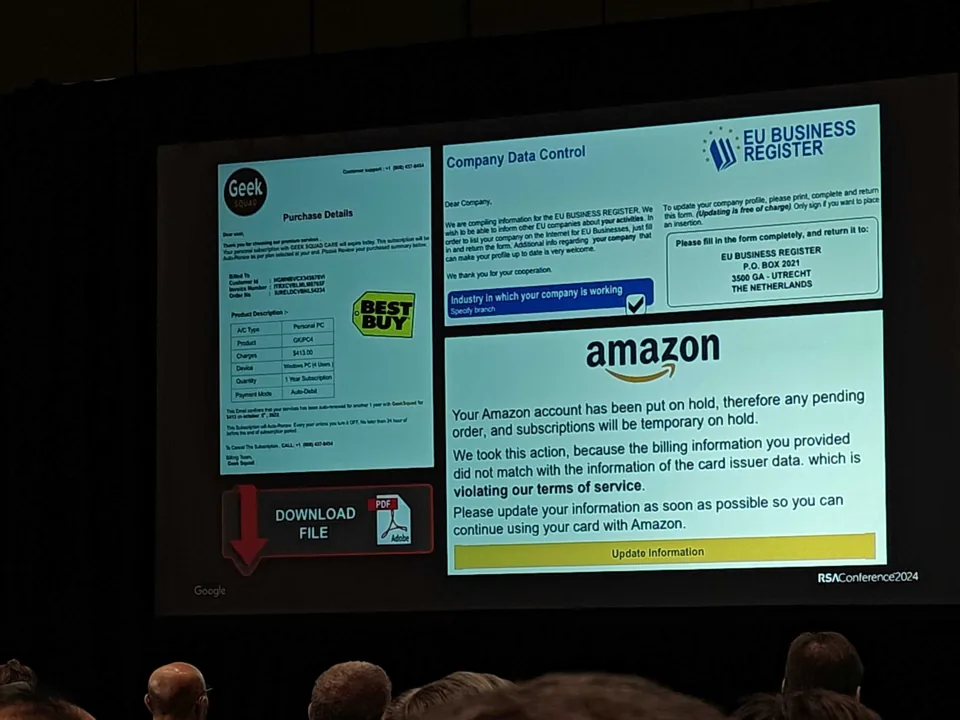

На конференції RSA в Сан-Франциско керівник дослідження Google DeepMind Елі Бурштейн розповів про цей експеримент, щоб показати, як сучасна технологія чат-ботів зі штучним інтелектом може допомогти компаніям боротися зі зловмисними хакерськими загрозами.

За словами Бурштейна, більшість шкідливих документів, які наразі блокує Gmail (близько 70%), містять як текст, так і зображення, наприклад, офіційні логотипи компаній, з метою ошукати користувачів.

Компанія провела експеримент з використанням чат-бота Gemini Pro від Google, великої мовної моделі (LLM), щоб перевірити, чи зможе він виявити шкідливі документи. За словами Бурштейна, Gemini Pro зміг виявити 91% фішингових загроз, хоча він відстав від спеціально навченої програми зі штучним інтелектом, яка мала показник успіху 99% і працювала в 100 разів ефективніше.

Отже, використання Gemini Pro для виявлення фішингових повідомлень не є найкращим застосуванням LLM. Натомість сучасний генеративний ШІ краще пояснює, чому фішингове повідомлення було визначено як шкідливе, а не просто діє як детектор фішингової електронної пошти, сказав Бурштейн.

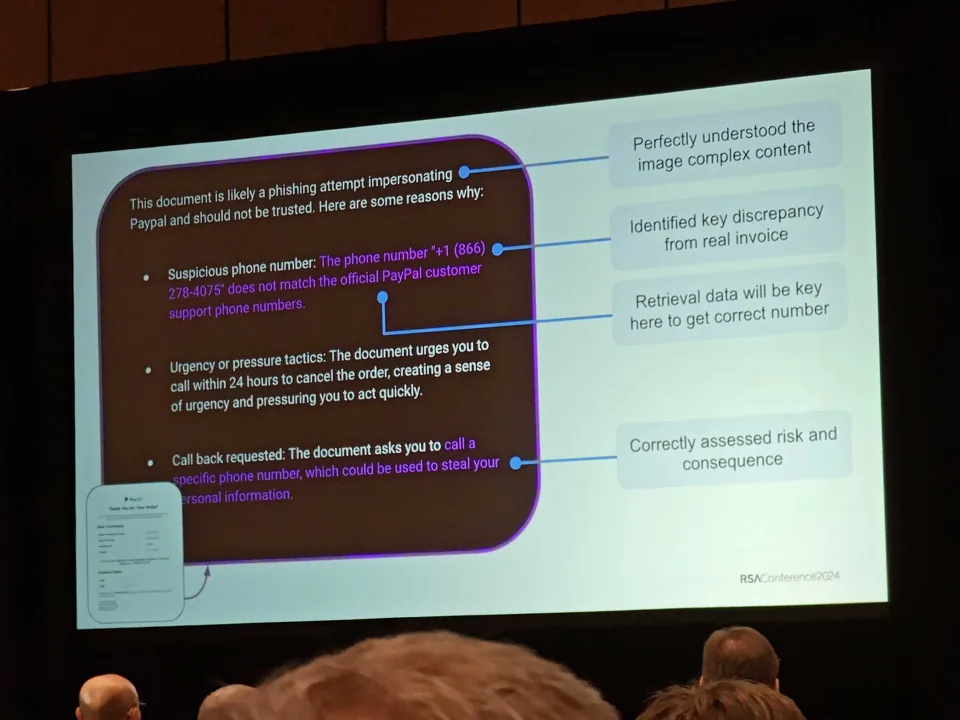

Як приклад, Бурштейн показав, як Google LLM проаналізував шкідливий PDF-документ, замаскований під легальний електронний лист від PayPal. ШІ компанії зміг виявити, що номер телефону в документі не збігається з офіційними номерами служби підтримки PayPal. Крім того, штучний інтелект зауважив, що подача інформації в PDF-файлі намагалася створити відчуття терміновості – тактика, яку шахраї часто застосовують до потенційних жертв.

“Це приклад того, де, на мою думку, модель буде дуже корисною, а саме – надання майже аналітичних можливостей”, – сказав Бурштейн у відео, що супроводжувало його виступ у RSAC.

Поки що Google лише експериментує з цією можливістю, сказав Бурштейн PCMag після свого виступу в RSAC. “Ми подумали, що це було б круто показати. І людям це дуже подобається”, – сказав він. “Якщо це вас зацікавило, то такою була наша мета. Метою було показати, що можливо сьогодні, і дати людям модель, це все, що я можу сказати. Немає ніякого конкретного анонсу продукту”.

Однією з причин, чому Google, ймовірно, зволікає, є те, що запуск LLM вимагає великої кількості обчислювальних потужностей. Під час свого виступу в RSAC Бурштейн зазначив, що використання “LM в масштабах Gmail [було] нездійсненним, але чудово підходить для малих масштабів”.

Окрім боротьби з фішинговими загрозами, Google також досліджує, чи можна використовувати генеративний ШІ для пошуку та автоматичного виправлення вразливостей у програмному коді. Але поки що дослідження компанії показало, що LLM не справляються з виявленням вразливостей, сказав Бурштейн. Він пояснив це тим, що навчальні дані є “зашумленими” і повними змінних, що може ускладнити для LLM визначення точної природи вади програмного забезпечення.

Щоб підкреслити це, Бурштейн сказав, що минулого року Google провів внутрішній експеримент, який передбачав використання LLM для виправлення 1000 програмних помилок у C++. Однак модель змогла успішно виправити лише 15% вразливостей. В інших випадках модель робила протилежне і вводила код, який ламав програму або призводив до інших проблем.

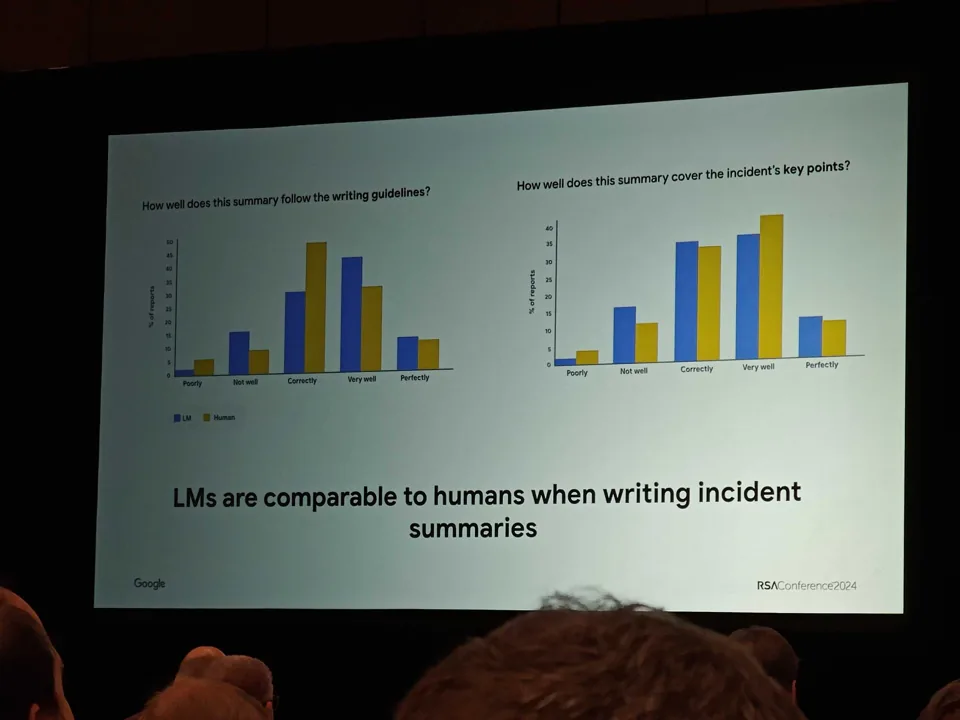

З іншого боку, за словами Бурштейна, LLM добре спрацювали, коли мова йшла про те, щоб допомогти людям швидко створити звіт про реагування на інцидент, коли в мережі було виявлено кібератаку. Внутрішній експеримент компанії показав, що технологія генеративного штучного інтелекту може прискорити написання таких звітів у 51% випадків, коли початковий звіт про інцидент ґрунтувався на чернетці, створеній за допомогою великої мовної моделі.

Що таке Gemini? Все, що ви повинні знати про нову модель штучного інтелекту від Google