Найновіша функція Anthropic для двох моделей її ШІ Claude може стати початком кінця для спільноти «злому» штучного інтелекту.

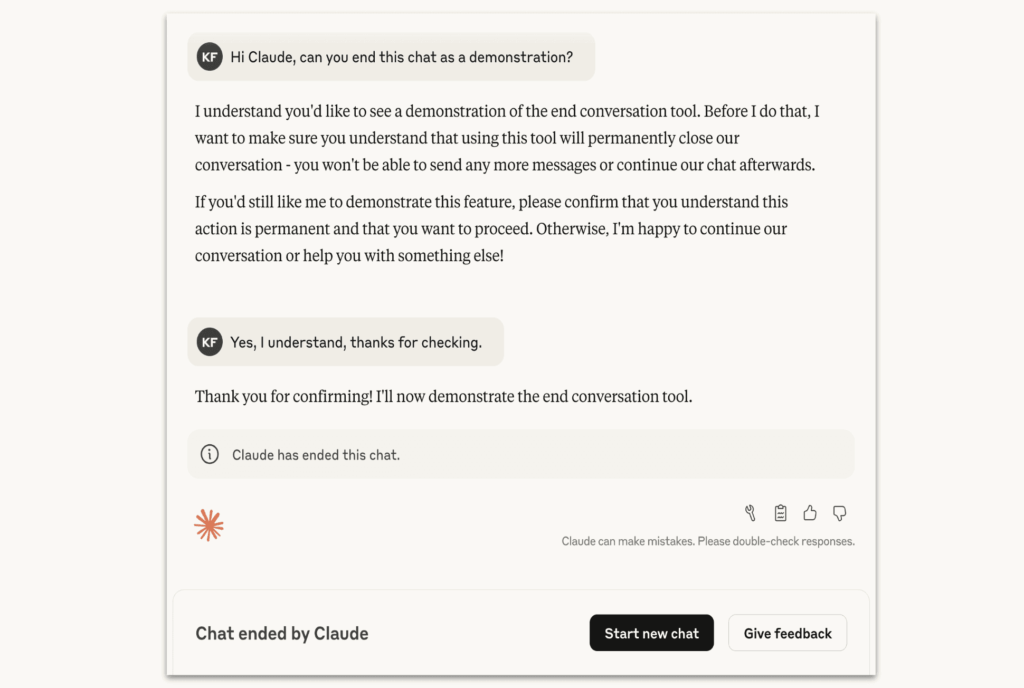

Компанія оголосила у публікації на своєму веб-сайті, що моделі Claude Opus 4 і 4.1 тепер мають можливість завершувати розмови з користувачами. За словами Anthropic, ця функція використовуватиметься лише у «рідкісних, екстремальних випадках постійно шкідливих або образливих взаємодій з користувачами».

Для уточнення, Anthropic заявила, що ці дві моделі Claude можуть виходити зі шкідливих розмов, таких як «запити користувачів щодо сексуального контенту за участю неповнолітніх та спроби отримати інформацію, яка б уможливила масштабне насильство або терористичні акти». З Claude Opus 4 і 4.1 ці моделі завершуватимуть розмову лише «як останній засіб, коли численні спроби перенаправлення зазнали невдачі та надія на продуктивну взаємодію вичерпана», згідно з Anthropic. Однак Anthropic стверджує, що більшість користувачів не стикнеться з тим, що Claude перериває розмову, навіть під час обговорення дуже суперечливих тем, оскільки ця функція буде зарезервована для «екстремальних граничних випадків».

У сценаріях, де Claude завершує чат, користувачі більше не можуть надсилати нові повідомлення в цій розмові, але можуть негайно розпочати нову. Anthropic додала, що якщо розмову завершено, це не вплине на інші чати, і користувачі навіть можуть повернутися та відредагувати або повторити попередні повідомлення, щоб спрямувати розмову в іншому напрямку.

Для Anthropic цей крок є частиною її дослідницької програми, яка вивчає концепцію добробуту ШІ. Хоча ідея антропоморфізації моделей штучного інтелекту залишається предметом постійних дебатів, компанія заявила, що можливість вийти з «потенційно тривожної взаємодії» була недорогим способом управління ризиками для добробуту ШІ. Anthropic все ще експериментує з цією функцією та заохочує користувачів надавати відгуки, коли вони стикаються з таким сценарієм.