Відтоді як програми штучного інтелекту почали вражати широку публіку, дослідники ШІ стали заявляти про глибше значення цієї технології, навіть стверджуючи про можливість людиноподібного розмірковування.

Науковці філософствують, бо навіть учені, які створили моделі ШІ на кшталт GPT-5 від OpenAI, насправді не розуміють повністю, як працюють ці програми, – пише ZDNET.

“Чорна скриня” ШІ та машина хайпу

Програми ШІ, такі як великі мовні моделі (LLM), є печально відомими “чорними скринями”. Вони досягають багато вражаючого, але здебільшого ми не можемо спостерігати все, що вони роблять, коли отримують вхідні дані (наприклад, промпт, який ви вводите) і видають результат (наприклад, курсову роботу, яку ви замовили, або пропозицію для вашого нового роману).

В цій прогалині науковці застосували розмовні терміни на кшталт “міркування” для опису роботи програм. При цьому вони або натякали, або прямо стверджували, що програми можуть “думати”, “міркувати” та “знати” так само, як люди.

За останні два роки риторика випередила науку, коли керівники ШІ-компаній використовували гіперболи, перетворюючи прості інженерні досягнення на щось більше.

Прес-реліз OpenAI минулого вересня про анонс їхньої моделі міркування o1 стверджував: “Подібно до того, як людина може довго думати перед відповіддю на складне питання, o1 використовує ланцюг міркувань при спробі вирішити проблему”, щоб “o1 навчається відточувати свій ланцюг міркувань і вдосконалювати стратегії, які використовує”.

Від цих антропоморфізуючих тверджень було лише крок до всіляких диких заяв, як-от коментар генерального директора OpenAI Сема Альтмана в червні: “Ми пройшли горизонт подій; злет розпочався. Людство близьке до створення цифрового суперінтелекту”.

Протидія з боку дослідників ШІ

Однак формується протидія з боку вчених у галузі ШІ, які розвінчують припущення про людиноподібний інтелект через ретельну технічну експертизу.

У статті, опублікованій минулого місяця на сервері препринтів arXiv і ще не рецензованій, автори – Ченгшуай Чжао та його колеги з Університету штату Арізона – розібрали твердження про міркування через простий експеримент. Їхній висновок: “міркування ланцюгом думок є крихким міражем” і це “не механізм для справжнього логічного висновку, а радше вишукана форма структурованого пошуку збігів шаблонів”.

Термін “ланцюг думок” (CoT) зазвичай використовується для опису багатослівного потоку виводу, який ви бачите, коли велика модель міркування, така як GPT-o1 або DeepSeek V1, показує вам, як вона опрацьовує проблему перед наданням остаточної відповіді.

Цей потік висловлювань не такий глибокий чи значущий, як здається, пишуть Чжао та команда. “Емпіричні успіхи міркування CoT призводять до сприйняття того, що великі мовні моделі (LLM) залучаються до навмисних інференційних процесів”, – пишуть вони.

Але “зростаючий обсяг аналізів показує, що LLM схильні покладатися на поверхневу семантику та підказки, а не на логічні процедури”, – пояснюють вони. “LLM конструюють поверхневі ланцюги логіки на основі вивчених асоціацій токенів, часто зазнаючи невдач у завданнях, що відхиляються від здоровоглуздих евристик або знайомих шаблонів”.

Термін “ланцюги токенів” – поширений спосіб посилання на серію елементів, що подаються на вхід LLM, таких як слова або символи.

Тестування того, що насправді роблять LLM

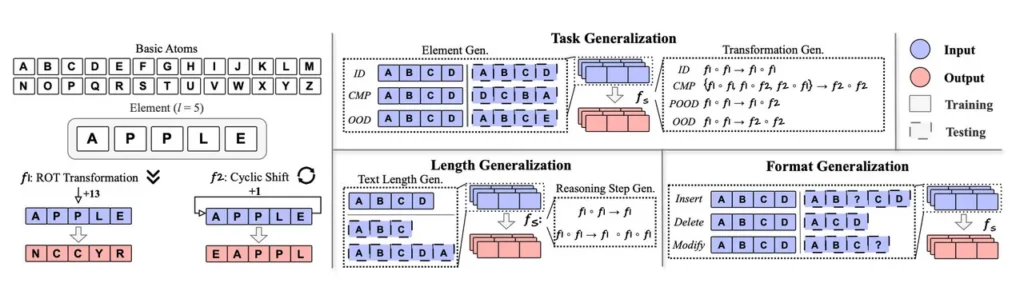

Щоб перевірити гіпотезу про те, що LLM лише шукають збіги шаблонів, а не справді міркують, вони навчили стару відкриту LLM від OpenAI – GPT-2 2019 року – з нуля, застосувавши підхід, який вони називають “алхімією даних”.

Модель навчали з самого початку лише маніпулювати 26 літерами англійського алфавіту: “A, B, C… тощо”. Цей спрощений корпус дозволяє Чжао та команді тестувати LLM набором дуже простих завдань. Усі завдання передбачають маніпулювання послідовностями літер, наприклад, зсув кожної літери на певну кількість позицій, щоб “APPLE” стало “EAPPL”.

Використовуючи обмежену кількість токенів і обмежені завдання, Чжао та команда варіюють, які завдання мовна модель бачить у своїх навчальних даних, а які – лише під час тестування готової моделі, наприклад: “Зсунь кожен елемент на 13 позицій”. Це тест того, чи може мовна модель знайти спосіб виконати завдання навіть при зіткненні з новими, ніколи раніше не баченими задачами.

Вони виявили, що коли завдань не було в навчальних даних, мовна модель не змогла правильно виконати ці завдання, використовуючи ланцюг думок. ШІ-модель намагалася використовувати завдання, які були в її навчальних даних, і її “міркування” звучить добре, але згенерована нею відповідь була неправильною.

Як кажуть Чжао та команда: “LLM намагаються узагальнити шляхи міркування на основі найбільш схожих […], які бачили під час навчання, що призводить до правильних шляхів міркування, але неправильних відповідей”.

Конкретність проти хайпу

Автори роблять кілька висновків.

По-перше: “Остерігайтеся надмірної довіри та помилкової впевненості”, радять вони, бо “здатність LLM виробляти ‘плавну нісенітницю’ – правдоподібні, але логічно хибні ланцюги міркування – може бути більш оманливою та шкідливою, ніж відверто неправильна відповідь, оскільки створює помилкову ауру надійності”.

Також варто випробовувати завдання, які явно навряд чи містилися в навчальних даних, щоб ШІ-модель пройшла стрес-тест.

Важливість підходу Чжао та команди полягає в тому, що він пробиває гіперболи і повертає нас до основ розуміння того, що саме робить ШІ.

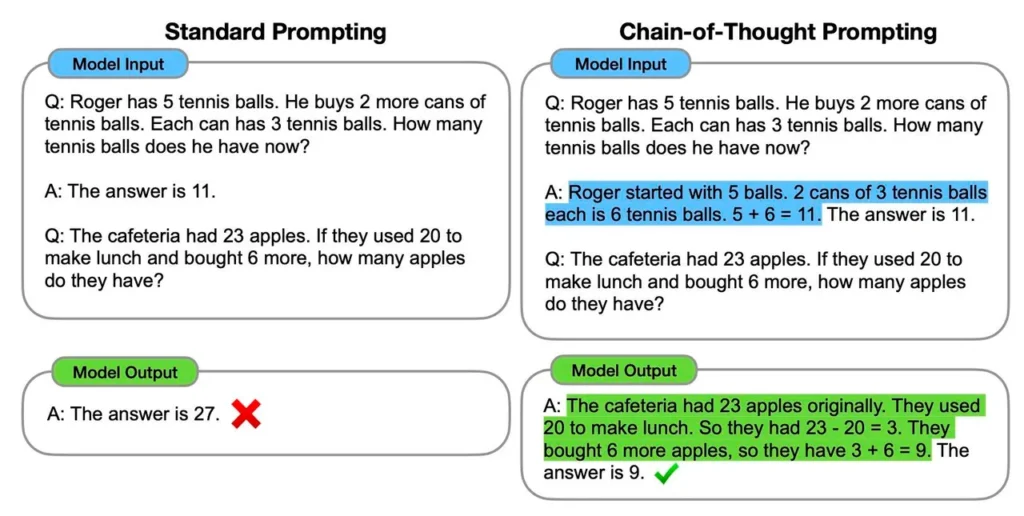

Коли оригінальне дослідження ланцюга думок “Chain-of-Thought Prompting Elicits Reasoning in Large Language Models” проводили Джейсон Вей та колеги з команди Google Brain у 2022 році – дослідження, яке з тих пір цитували понад 10 000 разів, – автори не заявляли про справжнє міркування.

Вей та команда помітили, що спонукання LLM перерахувати кроки в задачі, наприклад, арифметичній словесній задачі (“Якщо в банці 10 печива, а Саллі забрала одне, скільки залишилося в банці?”), як правило, призводило до більш правильних рішень у середньому.

Вони були обережні й не стверджували про людиноподібні здібності. “Хоча ланцюг думок наслідує мисленнєві процеси людини, це не відповідає на питання про те, чи насправді нейронна мережа ‘міркує’, що ми залишаємо як відкрите питання”, – писали вони тоді.

Відтоді заяви Альтмана та різні прес-релізи від промоутерів ШІ дедалі більше наголошували на людиноподібній природі міркування, використовуючи недбалу риторику, яка не поважає суто технічний опис Вея та команди.

Робота Чжао та команди нагадує нам, що ми повинні бути конкретними, а не забобонними щодо того, що насправді робить машина, і уникати гіперболічних заяв.