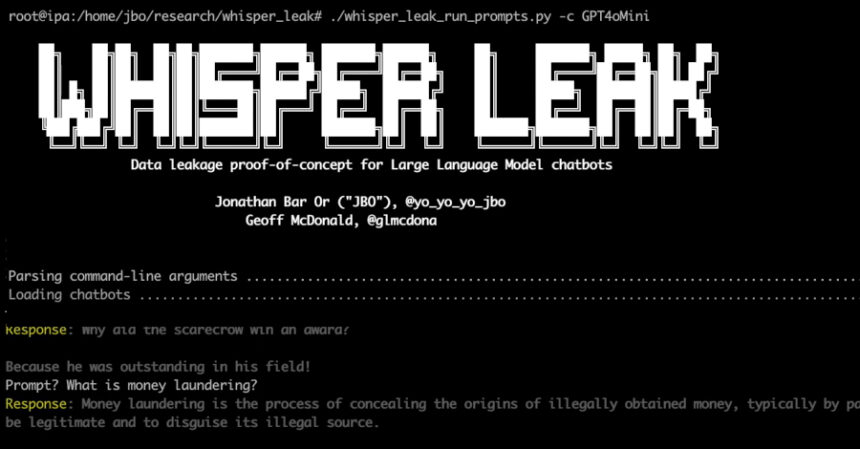

Дослідники Microsoft виявили нову атаку бічного каналу під назвою “Whisper Leak”, яка дозволяє зловмисникам визначати теми розмов з віддаленими мовними моделями штучного інтелекту, навіть якщо трафік зашифрований. Ця вразливість становить серйозну загрозу для конфіденційності користувачів AI-сервісів.

Такий витік даних між користувачами та мовними моделями в режимі потокової передачі може становити серйозні ризики для конфіденційності особистих та корпоративних комунікацій, зазначила компанія. Атаці присвоєно кодову назву Whisper Leak.

Як працює атака Whisper Leak

Атака Whisper Leak використовує аналіз розміру пакетів даних для визначення тематики розмов користувачів з AI-моделями. Навіть при використанні надійного шифрування, зловмисники можуть спостерігати за мережевим трафіком і робити висновки про зміст діалогів на основі патернів передачі даних.

Дослідники безпеки Джонатан Бар Ор і Джефф Макдональд разом із командою Microsoft Defender Security Research Team пояснюють, що атака працює через те, що різні типи запитів і відповідей генерують характерні послідовності пакетів різного розміру. Аналізуючи ці патерни, зловмисник може з високою точністю визначити, про що йде мова в розмові між користувачем і AI-асистентом.

Технічні деталі атаки

Whisper Leak базується на аналізі метаданих мережевого трафіку, а не на розшифруванні самого контенту. Атака використовує машинне навчання для класифікації патернів трафіку і може досягати точності понад 80% у визначенні тематики розмов.

Ключові характеристики атаки включають:

- Пасивність: зловмисникам не потрібно активно втручатися в комунікацію

- Масштабованість: можливість одночасного моніторингу множини користувачів

- Стійкість: ефективність навіть при використанні VPN та інших засобів захисту

Потокова передача та вразливість

Потокова передача у великих мовних моделях (LLM) — це технологія, яка дозволяє отримувати дані поступово під час генерації відповідей моделлю, замість очікування обчислення всього результату. Це критичний механізм зворотного зв’язку, оскільки певні відповіді можуть потребувати часу залежно від складності запиту або завдання.

Методика, продемонстрована Microsoft, є значущою тому, що працює, незважаючи на те, що комунікації з AI-чатботами зашифровані через HTTPS, який забезпечує безпеку вмісту обміну даними та унеможливлює його підробку.

За останні роки розроблено чимало атак через побічні канали на LLM, зокрема можливість визначати довжину окремих незашифрованих токенів за розміром зашифрованих пакетів у відповідях потокових моделей або використовувати часові різниці, спричинені кешуванням висновків LLM, для викрадення вхідних даних (атака InputSnatch).

Дослідження та результати

Whisper Leak розвиває ці висновки, досліджуючи можливість того, що послідовність розмірів зашифрованих пакетів і часу їх надходження під час відповіді потокової мовної моделі містить достатньо інформації для класифікації теми початкового запиту, навіть коли відповіді передаються групами токенів.

Для перевірки цієї гіпотези Microsoft навчила бінарний класифікатор як proof-of-concept, здатний розрізняти запити на конкретну тему та решту (шум) за допомогою трьох різних моделей машинного навчання: LightGBM, Bi-LSTM і BERT.

Результат показав, що багато моделей від Alibaba, DeepSeek, Mistral, Microsoft, OpenAI та xAI досягли показників понад 98%, що дозволяє зловмиснику, який моніторить випадкові розмови з чатботами, надійно визначати конкретну тему. Моделі від Google та Amazon продемонстрували більшу стійкість, ймовірно, завдяки пакетній обробці токенів, хоча вони не повністю імунні до атаки.

Потенційні загрози

«Якби урядова установа чи інтернет-провайдер моніторили трафік до популярного AI-чатбота, вони могли б надійно ідентифікувати користувачів, які ставлять запитання про конкретні конфіденційні теми — чи то відмивання грошей, політичний дисидентство чи інші контрольовані теми — навіть попри те, що весь трафік зашифрований», — зазначила Microsoft.

Дослідники виявили, що ефективність Whisper Leak може покращуватися в міру збору зловмисником більшої кількості навчальних зразків з часом, перетворюючи її на практичну загрозу. Після відповідального розкриття інформації OpenAI, Mistral, Microsoft та xAI впровадили заходи протидії цьому ризику.

«У поєднанні з більш складними моделями атак і багатшими патернами, доступними в багатокрокових розмовах або кількох розмовах від одного користувача, це означає, що кіберзловмисник з терпінням і ресурсами може досягти вищих показників успішності, ніж показують наші початкові результати», — додали в компанії.

Потенційні наслідки для користувачів

Витік інформації про теми AI-розмов може мати серйозні наслідки для приватності користувачів. Зловмисники можуть використовувати отримані дані для:

- Цільових фішингових атак на основі виявлених інтересів

- Промислового шпигунства через моніторинг корпоративних запитів

- Дискримінації на основі медичних або особистих запитів

- Соціальної інженерії з використанням профілів інтересів

Методи захисту

Ефективний контрзахід, розроблений OpenAI, Microsoft і Mistral, передбачає додавання випадкової послідовності тексту змінної довжини до кожної відповіді, що маскує довжину кожного токена і нівелює побічний канал.

Microsoft також рекомендує користувачам, які турбуються про конфіденційність під час взаємодії з AI-чатботами:

- Уникати обговорення надзвичайно конфіденційних тем при користуванні ненадійними мережами, такими як публічний Wi-Fi

- Використовувати VPN для додаткового рівня захисту

- Використовувати непотокові моделі LLM

- Переходити до провайдерів, які впровадили відповідні заходи захисту

Ширший контекст уразливостей LLM

Розкриття відбулося одночасно з новою оцінкою восьми LLM з відкритими вагами від Alibaba (Qwen3-32B), DeepSeek (v3.1), Google (Gemma 3-1B-IT), Meta (Llama 3.3-70B-Instruct), Microsoft (Phi-4), Mistral (Large-2), OpenAI (GPT-OSS-20b) і Zhipu AI (GLM 4.5-Air), яка виявила їхню високу сприйнятливість до адверсаріального маніпулювання, особливо у багатокрокових атаках.

«Ці результати підкреслюють системну нездатність поточних моделей з відкритими вагами підтримувати бар’єри безпеки протягом тривалих взаємодій», — зазначили дослідники Cisco AI Defense Емі Чанг, Ніколас Конлі, Харіш Сантаналакшмі Ганесан і Адам Сванда в супровідній статті.

«Ми оцінюємо, що стратегії узгодження та лабораторні пріоритети суттєво впливають на стійкість: моделі, орієнтовані на можливості, такі як Llama 3.3 і Qwen 3, демонструють вищу багатокрокову сприйнятливість, тоді як дизайни, орієнтовані на безпеку, такі як Google Gemma 3, показують збалансованішу продуктивність».

Висновки

Ці відкриття демонструють, що організації, які впроваджують моделі з відкритим кодом, можуть стикатися з операційними ризиками за відсутності додаткових бар’єрів безпеки. Це доповнює зростаючий масив досліджень, які виявляють фундаментальні вразливості безпеки в LLM та AI-чатботах з моменту публічного дебюту OpenAI ChatGPT у листопаді 2022 року.

Розробникам критично важливо впроваджувати адекватні заходи безпеки під час інтеграції таких можливостей у свої робочі процеси, тонко налаштовувати моделі з відкритими вагами для підвищення стійкості до зломів та інших атак, проводити періодичні AI red-teaming оцінки та впроваджувати суворі системні промпти, узгоджені з визначеними варіантами використання.

Експерти з кібербезпеки підкреслюють важливість цього дослідження для розуміння нових векторів атак у епоху широкого використання AI-технологій. Виявлення Whisper Leak демонструє, що навіть найсучасніші методи шифрування не завжди можуть повністю захистити конфіденційність користувачів.

Це дослідження Microsoft є черговим нагадуванням про те, що з розвитком AI-технологій з’являються нові виклики для кібербезпеки, які потребують постійної уваги та інноваційних рішень для захисту.