Діпфейки — це відео, підроблені за допомогою штучного інтелекту, які викликають дедалі більше занепокоєння урядів, правоохоронних органів і окремих людей. Ці фрагменти синтетичного носія можуть бути дуже переконливими та одного разу можуть підірвати нашу здатність довіряти власним очам. Але що таке технологія deepfake? І чому це так небезпечно?

Яка мета діпфейків?

Діпфейки можуть мати різні цілі, починаючи від старіння акторів у голлівудських блокбастерах і закінчуючи небезпечними пропагандистськими війнами проти політичних конкурентів.

Технологія Deepfake може створювати переконливі відео людей, зокрема політиків і знаменитостей, які нібито говорять і роблять те, чого вони насправді ніколи не робили. Програми Deepfake відносно доступні та прості у використанні та незабаром можуть зіграти важливу роль у кіноіндустрії.

Поєднайте це з тим фактом, що системи штучного інтелекту також можуть відтворювати аудіо певних людських голосів таким же чином, і хороший дипфейк стане потужним — і потенційно небезпечним — інструментом.

Як створюються діпфейкові відео?

Діпфейки створюються за допомогою систем штучного інтелекту, які використовують процес глибокого навчання для перегляду та відтворення медіа. У деяких випадках ці системи глибокого навчання використовують генеративну змагальну мережу; По суті, мережа штучного інтелекту розділена на два конкуруючі компоненти, які змагаються за навчання та покращення результатів.

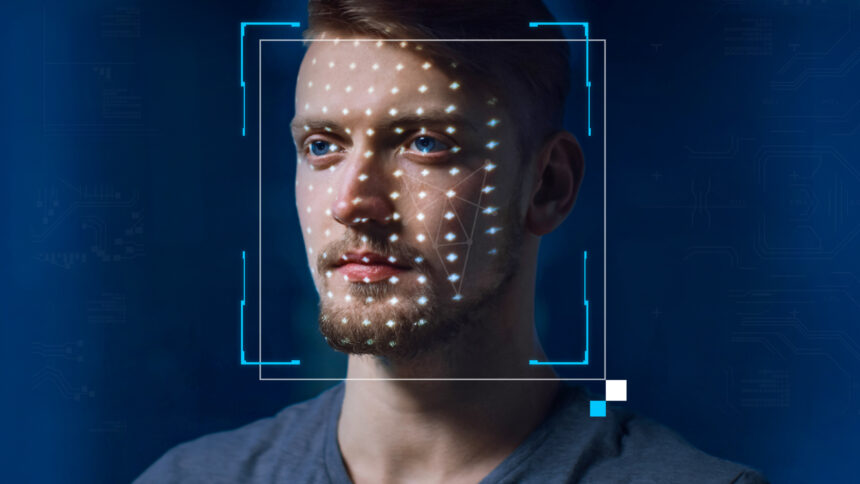

Діпфейк зазвичай включає відеоматеріали людини, як правило, актора. Це лише маріонетка, на яку згодом спроектують інше обличчя. Потім штучний інтелект переглядає сотні зображень різних людей і реалістично відтворює їхні риси. Зображення нового обличчя потім відображається на рухах актора, синхронізуючи вирази обличчя та рухи губ.

Незважаючи на те, що штучний інтелект deepfake все ще допрацьовується та вдосконалюється, він уже на дуже просунутій стадії та може швидко давати результати з мінімальним людським контролем.

Хто може робити діпфейки?

Будь-хто може створювати підроблені відео та зображення за допомогою різноманітних безкоштовних програм, таких як Wombo та FaceApp. Це прості програми, які не дають надто переконливих результатів, але це лише верхівка айсберга.

Художники, які створюють візуальні ефекти, шукали способи зменшити вік літніх акторів і навіть повернути на екран померлих знаменитостей. Ми бачили спроби позбавити віку Арнольда Шварценеггера у фільмі «Термінатор: Темна доля» та воскресити Пітера Кушинга у фільмі «Ізгой-один: Історія Зоряних війн».

Це були не діпфейки, а скоріше ретельні цифрові реконструкції, створені художниками візуальних ефектів. Що вражає в них, так це те, що багато художників-аматорів VFX створювали власні версії відповідних сцен із цих фільмів і використовували програмне забезпечення deepfake для створення ще кращих відтворень обличчя. Це демонструє захоплюючий і законний варіант використання deepfakes.

Ви можете переглянути деякі з цих переконливих відео, згенерованих штучним інтелектом, на YouTube разом із численними підробленими відео публічних діячів, таких як Дональд Трамп, Барак Обама та Том Круз, усі відтворені за допомогою цієї ж технології.

Чи діпфейки незаконні?

Діпфейки швидко завойовують погану репутацію як інструменти дезінформації, фейкових новин і шкідливого вмісту для дорослих. Однак самі по собі вони не є незаконними.

Існують законні способи використання дипфейків – їх роль у цифрових ефектах у фільмах є головною серед них – але вони також можуть використовуватися для незаконних дій, що є однією з головних причин, чому останнім часом вони привернули увагу суспільства.

Діпфейки іноді використовуються для незаконного створення порнографічних відео та зображень, часто з використанням образів знаменитостей і громадських діячів. Були навіть повідомлення про deepfake ботів , які можуть автоматично генерувати оголені фото людей.

Якщо це було недостатньо погано, ці фальшиві відео також можуть бути частиною пропагандистської стратегії урядів, щоб спробувати підірвати довіру до своїх ворогів.

Як розпізнати діпфейк

Виявити діпфейк не завжди легко. У той час як деякі є явно підробленими відео, вирази обличчя яких створюють сюрреалістичний ефект, інші є більш витонченими.

Кілька факторів можуть допомогти вам визначити, чи дивитеся ви на переконливе діпфейкове відео чи ні. Якщо на відео є обличчя, зосередьте на ньому свою увагу та знайдіть такі ознаки:

Гладкі або розмиті плями

Точки сполучення, де накладення відео deepfake стикається з обличчям людини під ним, іноді можуть виглядати дивно гладкими та без текстури. Навіть на кращих прикладах будь-які різкі рухи голови або зміни освітлення можуть на мить виявити розмиті межі обличчя.

Неточні риси обличчя

Якщо відео представляє публічну особу, наприклад політика, ви можете знайти зображення цієї особи для порівняння. Подивіться на елементи поза основними рисами обличчя, які, можливо, не були змінені; руки, волосся, форма тіла та інші деталі, які не синхронізуються між відповідним відео та старішими, більш надійними візуальними джерелами.

Неприродний рух

Принаймні на даний момент діпфейки виглядають переконливіше, коли об’єкт зйомки не надто рухається. Якщо тіло та голова суб’єкта здаються дивно жорсткими, це може бути ознакою того, що творці відео намагаються полегшити штучному інтелекту глибокого навчання відображення зображення на обличчі людини без необхідності відстежувати занадто багато рухів. .

Непереконливий голос

Технологія Deepfake швидко розвивається, але на даний момент навчання комп’ютерів створенню аудіосимуляцій, здається, дає гірші результати, ніж синтез переконливих зображень і відео.

Творець deepfake має вибрати між двома варіантами, якщо вони хочуть, щоб їхній суб’єкт говорив – або використовувати голос, створений штучним інтелектом, або актора, який може уособлювати вихідний матеріал. Ви можете порівняти голос зі звуком розмови знаменитості чи політика, і ви можете помітити деякі відмінності.

Чим загрожує технологія deepfake?

Технологія Deepfeke створює низку дуже реальних загроз для окремих людей і суспільства в цілому. Переконливі діпфейкові відео можуть бути надзвичайно шкідливими, якщо вони створені як порно з помсти та поширені в Інтернеті, тому багато країн починають запроваджувати закони, які криміналізують цю діяльність.

Декілька інших зростаючих загроз, що становлять діпфейки, ми розглянемо тут.

Фейкові новини та пропаганда

Переконливе діпфейкове відео може бути використано як пропаганда для дискредитації політичних опонентів і конкуруючих урядів. Для прикладу ми можемо поглянути на 2022 рік, коли невдовзі після російського вторгнення в Україну в мережі з’явилися дипфейкові відео, на яких показано капітуляцію українського президента.

Хоча це відео було викрито як фейк, легко уявити, наскільки згубною може бути ця стратегія, коли технологію стане важче виявити. Діпфейк можна використовувати для дискредитації політичного опонента та впливу на виборців. Крім того, широке використання цієї технології може бути використано для дискредитації дійсно викривального відео.

Якщо виявити діпфейкове відео стане неможливим, сфабриковані медіа можуть збільшити ризик фейкових новин і підпалити недовіру до основних ЗМІ.

Шахрайство та соціальна інженерія

Технологія Deepfake також може бути використана, щоб обманом змусити людей розкрити особисту інформацію або навіть віддати гроші за допомогою фішингових атак . Якщо ви отримуєте повідомлення на Facebook від друга, який пояснює, що він опинився за кордоном і потребує термінової фінансової допомоги, це може бути підозрілим. Можливо, ви зателефонуєте їм або напишете повідомлення в іншому додатку та дізнаєтесь, що їхній обліковий запис у Facebook зламано.

А тепер уявіть той самий сценарій, але замість повідомлення вам надсилають цілком переконливе відео вашого друга. Аудіо та відео здаються справжніми; Тепер у вас є те, що здається наочним доказом того, що вони справді застрягли в аеропорту, не маючи достатньо грошей на квиток додому. Багато людей надіслали б гроші, не відчуваючи потреби просити подальших запевнень, але те, що вони щойно побачили, може бути діпфейком.

Завдяки зростаючій складності генеративних змагальних мереж та інших систем машинного навчання шахраї незабаром зможуть використовувати ці переконливі відео, щоб полегшити крадіжку особистих даних і допомогти в подальшому шахрайстві.

Майбутнє діпфейків

З удосконаленням технології виявити діпфейки стане все важче. Якщо ми досягнемо того моменту, коли будь-хто з комп’ютером і базовим розумінням програмного забезпечення VFX зможе створити відео, на якому президент говорить щось обурливе, у нас будуть проблеми.

Вже важко помітити діпфейки, але скоро їх стане неможливо виявити. З поляризованою політичною системою не виключено, що дипфейк може бути використаний як частина прихованої стратегії кампанії. Хоча використання технології в останніх фільмах і телешоу допомагає підвищити обізнаність серед громадськості, багато людей все одно можуть бути дезінформовані переконливим відео.

Один простий крок, який ви можете зробити сьогодні, щоб протистояти ризикам, пов’язаним із шахраями deepfake, – це обмежити кількість зображень, які ви публікуєте в Інтернеті.Створення переконливого відео, згенерованого штучним інтелектом, покладається на те, що система отримує доступ до фотографій і кадрів об’єкта, який вона намагається відтворити. Ми радимо вам зберігати конфіденційність своїх профілів у соціальних мережах і уникати регулярних публікацій зображень свого обличчя.